홈페이지를 개설하면 트래픽을 늘리기 위해 검색 엔진(네이버, 구글 등)에 홈페이지를 등록합니다. 이런 검색 엔진들은 자체적인 검색 엔진 도구가 있는데, 네이버는 서치 어드바이저이고 구글은 서치 콘솔입니다. 이 중 서치 어드바이저는 몇 가지 지표로 검색 엔진에 최적화되어 있는지 아닌지를 알려줍니다.

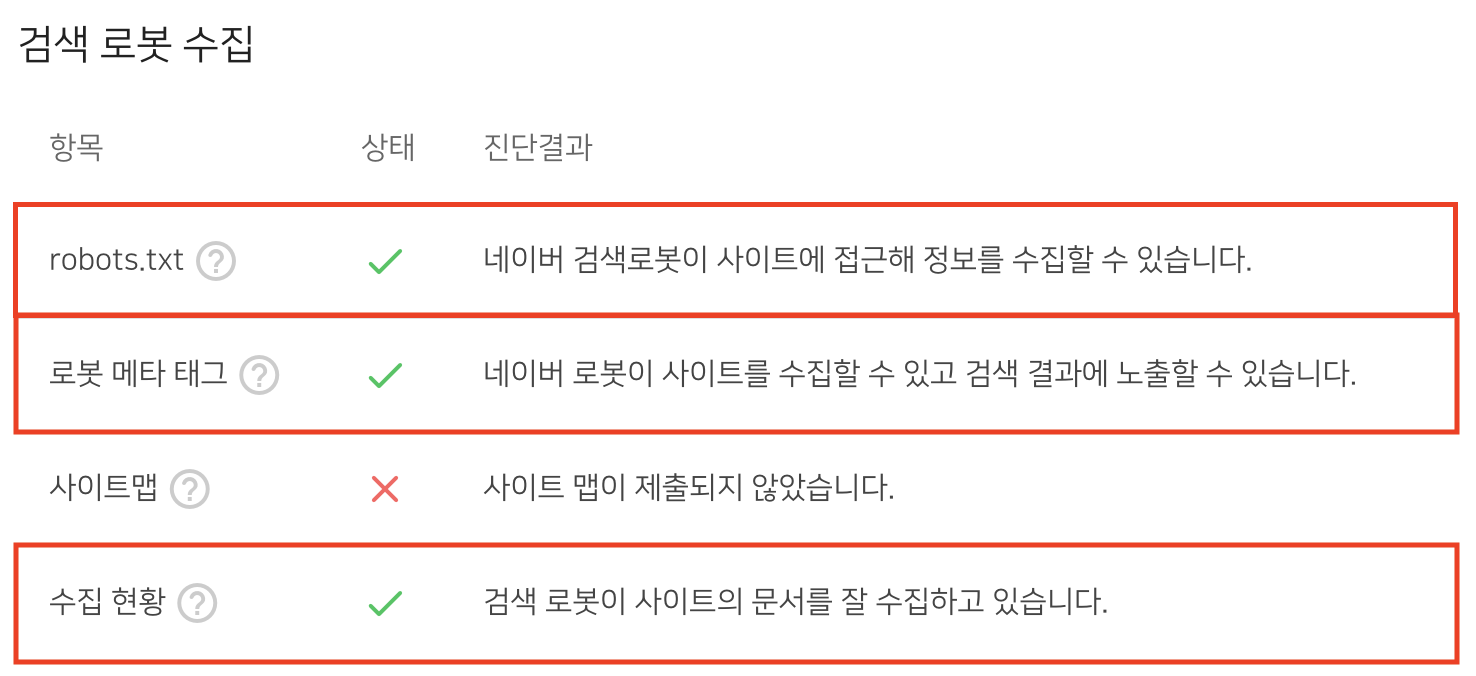

위 서치어드바이저 리포트 캡쳐 화면은 제가 아무것도 모르고 일단 생성한 웹페이지를 등록해서 나온 결과입니다. 다시 봐도 처참하네요 ;( 서치 어드바이저에 최적화하기 위해서 제가 노력한 것들을 공유하고자 포스팅을 작성하게 되었습니다. 제일 처음으로 리포트의 상단에 있는 검색 로봇 수집의 robots.txt와 로봇 메타 태그, 수집 현황을 개선한 방법을 정리했습니다.

robots.txt 생성하기

네이버의 검색엔진 등록 도구인 서치어드바이저에서 리포트 항목에 "robots.txt"가 있습니다. 이건 사이트 루트 폴더에 robots.txt 파일이 있는지 없는지를 확인하는 항목입니다. 보통(?) index.html이 있는 곳에 robots.txt 파일이 있습니다.

robots.txt 파일은 네이버 서치어드바이저에서 간단하게 생성할 수 있습니다. 모든 검색로봇에 대해서 수집을 허용하는 게 일반적입니다.

# 모든 검색 엔진에 대해 수집 허용

User-agent: *

Allow: /

네이버 서치어드바이저(Yeti), 구글 서치 콘솔(Googlebot)만 검색을 허용하도록 설정할 수 있고, 폴더에 대해서 disallow를 설정할 수도 있습니다. 네이버에서 제공하는 네이버 사이트 검색 이해하기 문서가 비전공자도 잘 이해하게 설명되어 있어서 아래에 첨부했습니다.

검색로봇 접근 제어하기 (로봇 메타 태그)

robots.txt에서는 폴더에 대한 접근 권한만 설정할 수 있었습니다. 만약 같은 위치에 있는 index.html은 검색을 허용하고 test.html은 검색을 막고 싶다면, 로봇 메타 태그를 사용해야 합니다.

로봇 메타 태그가 없는 페이지는 기본적으로 수집이 허용된 페이지로 인식합니다. 그래서 허용할 페이지에는 굳이 허용 코드를 삽입하지 않아도 됩니다. 하지만 검색을 막고 싶은 페이지에는 아래 코드를 삽입해야 합니다.

<!-- 검색엔진 수집을 막고싶은 페이지의 head에 아래 코드 추가하기 -->

<meta name=“robots” content=“index”>

검색엔진에서는 robots.txt, 로봇 메타 태그가 모두 허용으로 설정되어 있어야 페이지 수집이 가능합니다. 폴더 별로 검색엔진 접근을 관리하고 싶다면 robots.txt에서, 페이지 별로 관리하고 싶다면 로봇 메타 태그로 설정하면 됩니다.

위 설정을 모두 끝내면 서치어드바이저>리포트>사이트 최적화> 검색 로봇 수집의 robots.txt, 로봇 메타 태그, 수집 현황에서 초록 체크를 받을 수 있습니다. 검색 엔진 최적화를 위해서 갈 길이 멀지만 간단한 설정으로 3개를 합격(?)해서 만족스럽습니다. 다음에는 사이트맵 생성 포스팅을 정리해보겠습니다 :>

잘못된 내용이 있다면 언제든지 댓글이나 메일로 알려주시면 감사하겠습니다.

이 포스팅이 도움이 되었다면 공감 부탁드립니다.

궁금한 점은 언제든지 댓글 남겨주시면 답변해드리겠습니다:D

'major > Web' 카테고리의 다른 글

| .htaccess 파일로 http→https 리다이렉트 설정하기 (1) | 2021.04.25 |

|---|---|

| 사이트맵 만들고 제출하기 (0) | 2021.03.23 |

| favicon(파비콘) 설정 및 갱신 오류 해결방법 (1) | 2021.03.21 |

| [JavaScript] xmlHttpRequest 사용법 (0) | 2020.05.02 |

| [JavaScript] To Do List 만들기 (11) | 2020.04.29 |